Model AI to nie mózg – to maszyna, która zgaduje

Zacznijmy od podstaw. Model AI nie myśli. Nie rozumie danych. On tylko szuka wzorców, które wcześniej widział. Jeśli dane treningowe są pełne błędów, nieaktualne albo przedstawiają tylko część rzeczywistości – model przejmie te same ograniczenia.

Przykład z życia: model AI do oceny CV nauczył się faworyzować kandydatów z dużych firm, bo dane treningowe pochodziły głównie z korporacji. Efekt? Kandydaci z mniejszych firm byli oceniani znacznie gorzej – mimo że w praktyce często byli lepiej dopasowani do stanowiska.

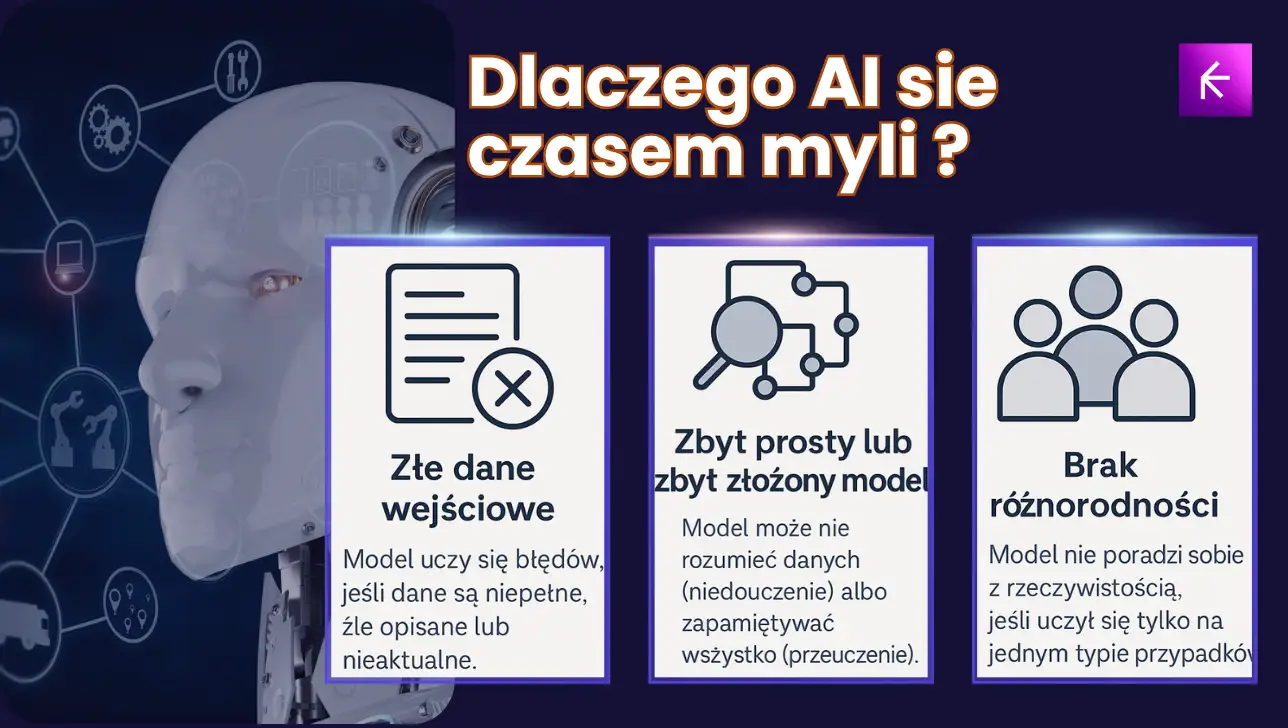

Skąd się biorą błędy? Oto 3 główne powody

Po pierwsze: złe dane. To mogą być literówki, źle opisane przypadki, nieaktualne informacje albo zbyt mało przykładów nietypowych sytuacji. Model nie ma szans nauczyć się czegoś, czego nigdy nie widział.

Po drugie: niewłaściwa konstrukcja modelu. Zbyt prosty model nie uchwyci sensu danych (underfitting). Zbyt skomplikowany może nauczyć się nawet szumu i przypadków (overfitting), przez co działa dobrze na treningu, ale źle w praktyce.

Po trzecie: brak różnorodności danych. Jeśli uczysz model tylko na jednym rodzaju przypadków, nie poradzi sobie z resztą. To jakby uczyć się prowadzenia auta wyłącznie na autostradzie i oczekiwać sukcesu w centrum Neapolu.

Jak sprawdzić, czy Twój model się nie myli za często?

Nie trzeba być programistą, żeby ocenić jakość modelu. Oto kilka prostych pytań, które warto zadać:

- Czy model osiąga podobne wyniki na danych treningowych i testowych?

- Czy potrafi dobrze radzić sobie z przypadkami nietypowymi albo rzadkimi?

- Czy zachowuje się podobnie dla różnych grup użytkowników lub danych?

Czasem wystarczy po prostu przyjrzeć się wynikom: czy są sensowne, spójne, logiczne? A jeśli masz zespół – pozwól kilku osobom przetestować model na własnych przypadkach. Ich intuicja może wychwycić rzeczy, których liczby nie pokażą.

Metoda „zdrowego rozsądku” – czyli test użytkownika

W praktyce najlepiej sprawdza się po prostu test ręczny. Daj modelowi kilka przykładów z życia – także trudnych, nieoczywistych. Zobacz, jak sobie radzi.

Niech użytkownik końcowy (np. specjalista, klient lub pracownik działu) sprawdzi, czy model faktycznie pomaga, czy tylko wygląda dobrze w Excelu. AI może robić wrażenie, ale jeśli nie rozwiązuje konkretnego problemu – nie ma sensu.

Kiedy „błąd” jest akceptowalny?

Nie ma modeli idealnych. Każdy system AI się myli. Pytanie brzmi: czy jego błędy są kosztowne?

Jeśli model ma odróżniać zdjęcia psów od kotów – można mu wybaczyć pomyłkę. Ale jeśli podejmuje decyzje finansowe, medyczne albo wpływa na reputację firmy – każda pomyłka może być bolesna. Dlatego tak ważne jest nie tylko pytanie „czy działa?”, ale też „co się stanie, gdy się pomyli?”.

Podsumowanie: AI nie myśli – więc Ty musisz

AI nie zastąpi zdrowego rozsądku. Modele mogą być szybkie, precyzyjne i imponujące – ale zawsze działają w granicach tego, czego zostały nauczone. To użytkownik (Ty, Twój zespół, Twoja firma) musi zadać sobie kluczowe pytania: skąd są dane, jak wygląda rzeczywisty kontekst, czy model rozwiązuje realny problem?

Najlepsze projekty AI powstają wtedy, gdy człowiek i maszyna współpracują – nie wtedy, gdy jeden bezkrytycznie ufa drugiemu.

Chcesz mieć pewność, że AI w Twojej firmie naprawdę działa i się opłaca?

Podobne artykuły

AI w praktyce

Od czego zacząć z AI w firmie? Nie od ChatGPT.

AI w praktyce

AI w praktyce: jak działa, do czego służy i gdzie ma sens

ZROZUM AI

Autoregresja vs dyfuzja – dwa podejścia, które definiują współczesne modele AI

AI w praktyce

Agenci AI w 2026: Co to jest i dlaczego każda firma powinna o tym wiedzieć